Multithreading Reduzierter Rechenaufwand durch Preemption-Threshold Scheduling (PTS)

Der Verarbeitungsaufwand eines voll präemptiven Schedulers in einem Echzeitbetriebssystem kann zu Lasten der Systemeffizienz gehen. Das PTS-Verfahren ermöglicht die Voraussetzungen für mehr Leistung.

Anbieter zum Thema

Echtzeitfähige Embedded-Systeme nutzen in der Regel mehrere Applikations-Tasks oder Threads, die ihr Arbeitsaufkommen jeweils im Rahmen der Echtzeitvorgaben bewältigen müssen. Um zu garantieren, dass kritische Threads umgehend berücksichtigt werden und ihre zeitlichen Restriktionen einhalten können, verwendet man in Echtzeit-Systemen meist das so genannte „präemptive Scheduling“. Nachteilig an diesem Verfahren ist, dass es unter bestimmten Umständen eine erhebliche Anzahl an Kontextwechseln erzeugt.

Abhilfe kann hier eine als „Preemption-Threshold Scheduling“ (PTS) bezeichnete Technik schaffen, die einerseits den Verarbeitungsaufwand durch die vorzeitige Unterbrechung von Tasks reduziert, andererseits aber dafür sorgt, dass die Applikationen die gestellten Echtzeit-Anforderungen erfüllen.

Prioritäten der Threads einer Applikation

Den Threads einer Applikation werden Prioritäten zugeordnet. Diese geben ihre relative Wichtigkeit an und entscheiden über die Reihenfolge, in der sie die CPU nutzen dürfen, wenn alle Threads zur Ausführung bereit sind. Die Prioritäten werden in der Regel mit ganzen Zahlen von 0 bis n angegeben, wobei 0 je nach Anwendung für die höchste oder die niedrigste Priorität stehen kann. Im Betriebssystem ThreadX etwa ist 0 die höchste Priorität, die mit zunehmendem Zahlenwert geringer wird. Jedem Thread wird eine Priorität zugewiesen, die jedoch während des Betriebs dynamisch geändert werden kann. Mehrere Threads können die gleiche Priorität haben, oder es kann jedem Thread eine eigene Priorität zugewiesen werden.

Wenn ein Thread verarbeitet wird und während dieser Zeit ein anderer Thread mit höherer Priorität in den READY-Status wechselt, d. h. verarbeitungsbereit wird, unterbricht das RTOS den laufenden Thread (Präemption) und startet stattdessen die Verarbeitung des Threads mit höherer Priorität. Dieser Vorgang wird als Kontextwechsel bezeichnet. Bei einem Kontextwechsel legt das RTOS den Kontext des laufenden Threads auf den Stack und holt aus dem Stack den Kontext des neuen Threads, um ihn in die Register und den Programmzähler der CPU zu laden. Der Kontext des bisher laufenden Threads wird also durch den des neuen Threads ersetzt.

Ein solcher Kontextwechsel ist ein recht komplexer Vorgang, der je nach RTOS und Prozessor zwischen 50 und 500 Zyklen beanspruchen kann. Dieser große Aufwand ist auch der Grund für die große Sorgfalt, die bei Echtzeit-Betriebssystemen auf die Optimierung der Kontextwechsel sowie darauf verwendet wird, die Häufigkeit dieses Vorgangs zu minimieren. Diesem Ziel dient auch das Preemption Threshold Scheduling (PTS).

Anwendungen, die aus mehreren Funktionen (d. h. mehreren Threads oder Tasks) zusammengesetzt sind, benötigen einen Mechanismus, der für die Ausführung der jeweils erforderlichen Funktion sorgt. Eine Möglichkeit ist es, die Threads der Reihe nach zyklisch zu starten. Verfeinern lässt sich dieses ‚Big-Loop‘-Verfahren durch eine Statusprüfung, sodass nur die Funktionen gestartet werden, die tatsächlich etwas zu tun haben, während die anderen übersprungen werden. Derartige Schleifen sind bereits eine rudimentäre Form eines Schedulers, obwohl sie ineffizient sind und es ihnen an Reaktionsschnelligkeit mangelt, speziell wenn die Zahl der Threads und Funktionen zunimmt. Ein RTOS-Scheduler hat dagegen stets den Überblick oder kann schnell entscheiden, welche Aktivität zum jeweiligen Zeitpunkt verarbeitet werden muss.

Echtzeit-Scheduler arbeiten in aller Regel präemptiv. Sie sorgen also stets dafür, dass der Thread mit der höchsten Priorität ausgeführt wird, während die übrigen Threads warten müssen. Auch RTOS-Scheduler können das zyklische Round-Robin-Scheduling nutzen, das große Ähnlichkeit mit dem erwähnten Big-Loop-Verfahren hat. Ebenso kommt eine etwas ausgefeiltere Variante des Round-Robin-Schedulings in Frage, bei dem den einzelnen Threads jeweils ein bestimmter Prozentsatz der CPU-Zeit zugewiesen wird, anstatt die einzelnen Threads so lange laufen zu lassen, bis sie beendet sind oder ihre Arbeit aus eigenem Antrieb unterbrechen.

Der RTOS-Scheduler führt Kontextwechsel nach Bedarf aus und gibt den Threads die Möglichkeit, in den Sleep-Status zu wechseln, die CPU-Nutzung abzutreten oder ihre Ausführung zu beenden und den Pool der auf die CPU wartenden Threads zu verlassen. Der maximalen Reaktionsgeschwindigkeit steht allerdings ein großer Verarbeitungsaufwand gegenüber, da es niemals ohne Kontextwechsel geht.

Dem „Verhungern“ von Threads entgegenwirken

Das Präemptions-Konzept ist mit einer Reihe von Problemen behaftet, die von den Entwicklern entweder umgangen oder bei der Programmierung einer Applikation berücksichtigt werden müssen.

Das erste Problem wird als Thread Starvation, also das Verhungern eines Threads, bezeichnet. In diesem Fall gelangt ein Thread niemals zur Ausführung, weil die Verarbeitung eines Threads mit höherer Priorität nicht endet. Entwickler sollten deshalb die Situation vermeiden, dass ein Thread hoher Priorität in eine Endlosschleife gerät oder übermäßig viel CPU-Zeit beansprucht, wodurch anderen Threads die Nutzung des Prozessors verwehrt wird.

Das zweite Problem ist der hohe kumulative Verarbeitungsaufwand, wenn es zu vielen Kontextwechseln kommt. Weiter unten wird dieser Fall an einem Beispiel beschrieben und es werden Tools vorgestellt, mit denen sich der Verarbeitungsaufwand sichtbar machen und messen lässt.

Das dritte Problem ist die Prioritätsinversion. Hier wartet ein Thread mit hoher Priorität auf eine gemeinsam genutzt Ressource. Diese aber wird von einem Thread niedriger Priorität beansprucht, der die Ressource aber nicht freigeben kann, weil er von einem Thread mit dazwischen liegender Priorität unterbrochen wird.

Weniger Kontextwechsel – weniger Verwaltungsaufwand

An dieser Stelle kommt das Konzept des Preemption-Threshold Scheduling (PTS) zum Tragen. Hierbei wird eine bestimmte Prioritätsgrenze festgelegt, die ein Thread überschreiten muss, um einen Thread zu unterbrechen. Da das PTS-Verfahren einige Präemptionen verhindert, werden einige Kontextwechsel unterbunden, sodass sich der Verarbeitungsaufwand entsprechend verringert.

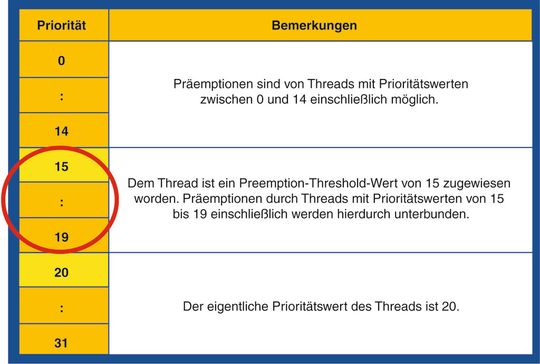

Normalerweise kann ein Thread von jedem anderen Verarbeitungsstrang unterbrochen werden, dessen Priorität höher ist. Beim PTS-Verfahren ist die Präemption eines Threads dagegen nur möglich, wenn die Priorität des unterbrechenden Threads höher ist als die Präemptions-Schwelle (Preemption Threshold) des gerade laufenden Threads. In einem vollständig präemptiven System ist der Preemption-Threshold-Wert identisch mit der Priorität des Threads. Setzt man den Preemption-Threshold-Wert dagegen höher an als die eigentliche Priorität des Threads, werden Präemptionen durch Threads, deren Priorität zwischen beiden Werten liegt, unterbunden.

(ID:37563520)

:quality(80)/p7i.vogel.de/wcms/59/bf/59bfd2822d711b0ae2cb9383b679f38d/0129302533v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/94/c19403fe0194686b2f4911be7e1e9539/0129294209v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e6/72/e67279e23a3267a463edf3e3f55c8e81/0129260553v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/28/0f/280fe550dfb032b53edbaac11d09bced/0129337134v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/21/29218000af0daabca33bf8a7947b61ad/0129310204v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/2b/5d/2b5d6ddedab3fdcaf528ff1caf650433/0129302953v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/57/7b5725dd2e7545ab4904a9b7a3735721/0129309389v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b2/9c/b29ce10d1817d4b67968dfb737d812b7/0129308255v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/c5/4bc5a6e591592fac9c3f05b77b8c237f/0129307845v4.jpeg)

:quality(80)/p7i.vogel.de/wcms/61/85/6185c7a5619aba866e3b237690bea839/0129334467v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/88/3c8863ad57e80adc0acb9c9d9ea30351/0129319571v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4e/f2/4ef224fde728985d8b9630eb0fa37909/0129293948v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/c7/f6/c7f61d0437c7f8fca3c6ff947ba2ad62/0129322490v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/0c/660c31afa35398bac9be42f2be73fdc4/0129073529v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/35/9c35ed04fa562b190cbc496a695a6802/0128823288v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d7/e6/d7e6fe4124ec2efc726e9c3f2c2a4cfc/0128241940v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e6/0a/e60ae162bd38bfc111ecf434d5c5fbd7/0129308123v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/c0/75c0d5ccd1cee4e66dbd5f3ed02efd0a/0129305300v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/a7/8c/a78c5f851db209abb1540909918fbf4a/0129260768v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9a/51/9a5199a5ad49e895b4aef7e04fe629e2/0129255110v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/d9/d6/d9d68c274ac9c3c728978fac46c773ba/0129239468v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/52/7a/527ad5ae7d10b9e34b72570639d7870c/plagiarius-zwerg-gnome-2849x1602v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/43/4343a389b15f84f683b7d1cdb4745d23/0129331527v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/89/6b/896bbee46d0440c8a01ce4d0dab325f0/0129302555v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/1f/691f39ba12be3cad90eb88bdabc456a6/0127321404v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/cc/6acc4f803241cfe5b6d60560c0a2b4d9/0126684948v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/aa/efaae5a25fb0a4c55c434611033447af/0126532350v2.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/9600/9682/65.jpg)

:fill(fff,0)/p7i.vogel.de/companies/69/72/69721860571ff/logo.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/68800/68851/65.jpg)

:quality(80)/p7i.vogel.de/wcms/0c/5e/0c5ec903121cf50480f570a3d256d375/0126571353v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/da/a8/daa8745a4503401d75471a8cbaa1416c/0123958001v1.jpeg)