Anbieter zum Thema

Im vorliegenden Beispiel könnte ein Thread mit der Priorität 20 von einem Thread unterbrochen werden, dessen Prioritätswert 19, 18, 17 usw. lautet. Wäre aber die Preemption Threshold des Threads auf 15 eingestellt, wäre eine Präemption nur durch Threads mit einer höheren Priorität als 15 (also einer niedrigeren Prioritätszahl) zulässig. Eine Präemption durch Threads mit den Prioritäten 19, 18, 17, 16 und 15 wäre somit ausgeschlossen, während sie bei Prioritäten von 14 und höher (also niedrigeren Prioritätszahlen) erlaubt wäre. Die Angabe einer Preemption Threshold ist optional und kann für alle Threads, bestimmte Threads oder keine Threads erfolgen. Ist kein Preemption-Threshold-Wert spezifiziert, können Präemptionen durch alle Threads mit höherer Priorität erfolgen. Ist dagegen eine Preemption Threshold angegeben, sind Präemptionen nur durch Threads zulässig, deren Priorität höher ist als der angegebene Wert.

Performance-Vorteile des PTS-Verfahrens

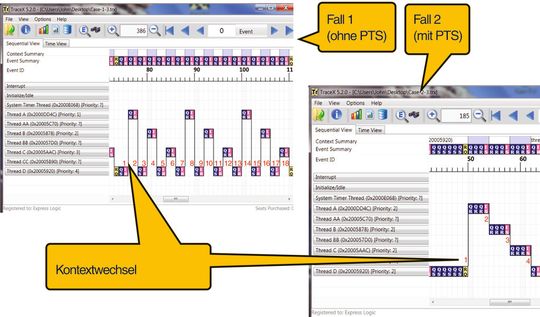

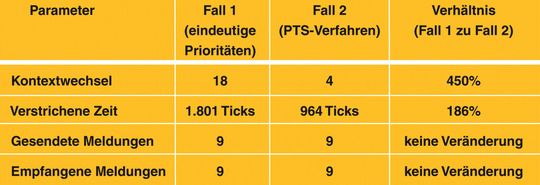

Um Einblick in die Abläufe der Applikation zu bekommen, werden alle Ereignisse aufgezeichnet. Aus den Aufzeichnungen werden anschließend die Zahl der Kontextwechsel und die verstrichene Zeit abgelesen, sodass Rückschlüsse gezogen werden können. Zum Vergleich beider Verfahren werden zwei Fälle betrachtet:

- In Fall 1 wird das vollständig präemptive Scheduling verwendet. Die Threads A, B, C und D haben die Prioritäten 1, 2, 3 und 4.

- In Fall 2 ist die Ausgangsposition gleich. Aber das PTS-Verfahren kommt ins Spiel, um zu sehen, wie sich die Zahl der Kontextwechsel damit reduzieren lässt. Zu diesem Zweck erhält der Thread D einen Preemption-Schwellwert von 1, sodass dieser Thread nur von einem Thread unterbrochen werden kann, dessen Priorität höher als 1 ist. Da es in diesem System keinen Thread mit der Priorität 0 gibt, ist diese Bedingung nie erfüllt, so dass der Thread D von den Strängen A, B oder C nicht unterbrochen wird.

In Fall 1 beginnt der Thread D mit dem Senden von Meldungen an die einzelnen Queues, doch sobald die erste Meldung gesendet ist, wird Thread A aktiv, um diese Meldung abzurufen. Thread A nämlich besitzt eine höhere Priorität als Thread D, und da die Warteschlange, auf die er gewartet hat, nun nicht mehr leer ist, ist Thread A zur Ausführung bereit. Hat Thread A die Meldung gelesen, wechselt er wegen der nunmehr wieder leeren Warteschlange erneut in den Wartestatus, sodass Thread D seine Arbeit wieder aufnehmen kann und eine Meldung an Thread B sendet, der daraufhin sofort Thread D unterbricht. So geht es weiter, bis alle neun Meldungen gesendet sind und der Zyklus beendet ist. Während dieses Durchlaufs wurden neun Meldungen gesendet, neun empfangen und 18 Kontextwechsel ausgeführt.

In Fall 2 sendet der Thread D seine Meldungen weiter, bis er auf eine nicht leere Warteschlange trifft und infolgedessen wartet, bis die Warteschlange wieder leer ist. Sobald Thread D stoppt, wird er nicht wieder gestartet, bis die Threads A, B und C angehalten werden, da er mit seiner Priorität 4 keinen anderen Thread unterbrechen kann.

Das Ergebnis von Fall 2 unterscheidet sich grundlegend von Fall 1, denn hier kommt es nur zu vier Kontextwechseln, während es im ersten Fall 18 waren. Eindrucksvoll ist auch ein Vergleich der Anzahl an Timer-Ticks. Sind es in Fall 1 insgesamt 1.801 Ticks, beträgt die Zahl in Fall 2 nur 964.

* * John A. Carbone ist Vice President für Marketing beim Betriebssystemhersteller Express Logic. Er lebt und arbeitet im kalifornischen San Diego.

(ID:37563520)

:quality(80)/p7i.vogel.de/wcms/59/bf/59bfd2822d711b0ae2cb9383b679f38d/0129302533v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/94/c19403fe0194686b2f4911be7e1e9539/0129294209v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e6/72/e67279e23a3267a463edf3e3f55c8e81/0129260553v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/28/0f/280fe550dfb032b53edbaac11d09bced/0129337134v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/21/29218000af0daabca33bf8a7947b61ad/0129310204v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/2b/5d/2b5d6ddedab3fdcaf528ff1caf650433/0129302953v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/57/7b5725dd2e7545ab4904a9b7a3735721/0129309389v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b2/9c/b29ce10d1817d4b67968dfb737d812b7/0129308255v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/c5/4bc5a6e591592fac9c3f05b77b8c237f/0129307845v4.jpeg)

:quality(80)/p7i.vogel.de/wcms/61/85/6185c7a5619aba866e3b237690bea839/0129334467v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/88/3c8863ad57e80adc0acb9c9d9ea30351/0129319571v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4e/f2/4ef224fde728985d8b9630eb0fa37909/0129293948v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/c7/f6/c7f61d0437c7f8fca3c6ff947ba2ad62/0129322490v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/0c/660c31afa35398bac9be42f2be73fdc4/0129073529v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/35/9c35ed04fa562b190cbc496a695a6802/0128823288v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d7/e6/d7e6fe4124ec2efc726e9c3f2c2a4cfc/0128241940v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e6/0a/e60ae162bd38bfc111ecf434d5c5fbd7/0129308123v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/c0/75c0d5ccd1cee4e66dbd5f3ed02efd0a/0129305300v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/a7/8c/a78c5f851db209abb1540909918fbf4a/0129260768v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9a/51/9a5199a5ad49e895b4aef7e04fe629e2/0129255110v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/d9/d6/d9d68c274ac9c3c728978fac46c773ba/0129239468v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/52/7a/527ad5ae7d10b9e34b72570639d7870c/plagiarius-zwerg-gnome-2849x1602v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/43/4343a389b15f84f683b7d1cdb4745d23/0129331527v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/89/6b/896bbee46d0440c8a01ce4d0dab325f0/0129302555v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/1f/691f39ba12be3cad90eb88bdabc456a6/0127321404v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/cc/6acc4f803241cfe5b6d60560c0a2b4d9/0126684948v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/aa/efaae5a25fb0a4c55c434611033447af/0126532350v2.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/9600/9682/65.jpg)

:fill(fff,0)/p7i.vogel.de/companies/69/72/69721860571ff/logo.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/68800/68851/65.jpg)

:quality(80)/p7i.vogel.de/wcms/0c/5e/0c5ec903121cf50480f570a3d256d375/0126571353v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/da/a8/daa8745a4503401d75471a8cbaa1416c/0123958001v1.jpeg)