Softwarequalität Falsches Testen – Teure Fehler

Qualitätssicherung kostet Geld, ebenso aber fehlerhafte Software. Für ein mangelhaftes Produkt können in Extremfällen die Haftungskosten sehr hoch werden. Dennoch ist eine Steigerung der Qualität aufgrund der dabei entstehenden Kosten nicht immer gerechtfertigt. Der Aufwand für die Qualität eines Produktes und die möglichen Kosten für nicht entdeckte Fehler müssen sich die Waage halten. Dies geschieht durch einen gut angepassten Testprozess.

Anbieter zum Thema

Die Tatsache, dass Software immer umfassender und möglichst effizient geprüft werden muss, dürfte unmittelbar einsichtig sein. Vielen potenziell fehlerhaften Geräten sind wir weitaus stärker ausgeliefert als nur mit der Verschwendung unserer Lebenszeit. Im medizinischen Bereich zum Beispiel sowie bei nahezu allen Transportmitteln kann ein Softwarefehler potentiell tödliche Konsequenzen haben. In anderen Fällen können schwerwiegende finanzielle, logistische und juristische Folgen auftreten, etwa bei Verwaltungs- oder Abrechnungssoftware.

Angesichts dessen ist es nur schwer verständlich, dass es trotz gut eingeführter und bewährter Techniken zur Sicherung von Softwarequalität immer noch Hersteller gibt, die, wenn sie auch nicht ganz darauf verzichten, so doch zumindest so unprofessionell zu Werke gehen, dass regelmäßig mangelhafte Produkte die Folge sind. Softwarequalität ist ein Teil des gesamten Produktqualitätsmanagements. Dies gilt für reine Softwareprodukte ebenso wie für Geräte, bei denen die Software nur einen verhältnismäßig geringen Anteil stellt. Als Hersteller sollte man zwei Dinge stets im Auge behalten: die Ansprüche des Endanwenders sind sehr hoch. Demzufolge ist die Frustrationstoleranz selbst bei kleineren Mängeln niedrig. Zum anderen haben Hersteller in Westeuropa nahezu keine andere Möglichkeit, auf Dauer global konkurrenzfähig zu bleiben, als über eine garantierte und gleichbleibend hohe Produktqualität.

Höhere Komplexität erfordert Umdenken bei Testverfahren

Aufgrund historischer Wurzeln wird gerade im mittelständischen Betrieben der Test nach wie vor am Schluss der Entwicklung durchgeführt. In den letzten Jahren ersetzt Software immer mehr Hardwarefunktionen, wobei der Anteil zunächst gering war und als Bestandteil von Hardwarebausteinen angesehen werden konnte. Die Hauptfunktionalität lag weiterhin bei der Hardware. In diesem Fall genügte der Endtest am Schluss der Hardwareintegration. Mit zunehmender Verlagerung der Funktionen auf die Software erhöht sich ihre Komplexität. Das erfordert zwingend andere Testverfahren, wie auch die Chancen für Fehlfunktionen größer werden. Mit dieser Verschiebung haben aber nicht alle Entwicklungsprozesse in den Firmen Schritt gehalten. Das Resultat: nicht mehr sachgerechte Testverfahren.

Die Komplexität des Testens wird oft unterschätzt, da nicht jeder die Verfahren und die assoziierten Problematiken (u.a auch psychosozialer Natur) des Testens kennt. Daher herrscht oft die Meinung vor, ein am Schluss der Integration durchgeführter Abnahmetest reiche aus. Aber: Wird zu dem Zeitpunkt ein architektonisch tiefliegender Fehler gefunden, können die Auswirkungen fatal sein. Je später im Produktionsprozess Fehler entdeckt werden, um so kostspieliger wird ihre Beseitigung.

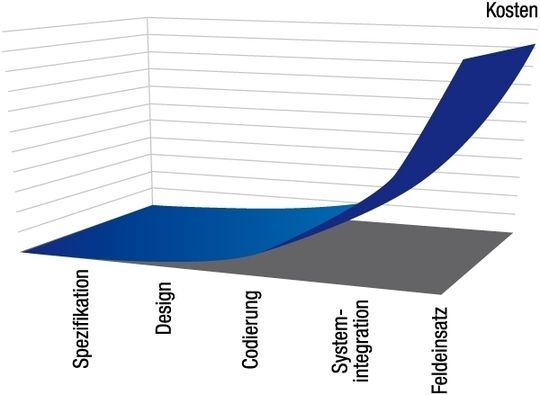

Es gibt zwei Phasen in der Produktion, mit denen die Kosten sprunghaft ansteigen (Bild 1): Sobald der erste Code geschrieben ist, und sobald die Systemintegration so fortgeschritten ist, dass der erste Feldeinsatz bevorsteht. Selbst nach sorgfältigem Testen muss erfahrungsgemäß von Restfehlern ausgegangen werden (Restfehlerrate). Sie liegt durchschnittlich bei ein bis zwei Fehlern pro 1000 Codezeilen, davon können wiederum 3 bis 10% schwerwiegend sein.

Im Avionikbereich, die Software für Flugzeugsteuerung und Flugsicherung herstellt, werden die strengsten Sicherheitsmaßnahmen angewendet. Dennoch gehen Schätzungen von 200 oder mehr verbliebenen, potentiell schwerwiegenden Softwarefehlern in einer Flugzeugsoftware aus. In einem bekannten Fall fiel bei extrem schwerem Wetter mit hohen Rollraten die Software eines Flugzeugs aus. Ursache dafür war, dass die Neigungswinkel vom System als unplausibel eingestuft wurden, was wiederum einen Neustart zur Folge hatte.

Dies zeigt: Nicht die eigentlich richtig arbeitende Software an sich war das Problem, sondern die falsche Einschätzung der Ingenieure. Verbliebene potentielle Restfehler sind weniger Codierungsfehler (wie vertauschte Vorzeichen oder < und >), sondern sie stammen von grundsätzlichen architektonischen Fehlern sowie falschen und nicht genügend durchdachten Annahmen, denen Entscheidungen des Systems zugrundeliegen.

Testverfahren müssen über den kompletten Entwicklungsprozess hinweg genutzen werden

Diese Tatsache impliziert zwei Hauptansätze zur Qualitätssicherung bei Software:

- Vorbeugende Fehlervermeidung,

- Kontrolle auf implementierte Fehler.

Vorbeugende Fehlervermeidung wird in erster Linie während des Designprozesses eingesetzt. Da bis zu diesem Zeitpunkt nur wenig lauffähiger Code existiert, zielen die Maßnahmen auf Reviews von Dokumenten ab (siehe Beiträge „Statische Softwaretests“, InfoClick am Ende de Beitrags). Reviews und Inspektionen zählen, früh genug im Entwicklungsprozess eingesetzt, zu den effektivsten und gleichzeitig kostengünstigsten Maßnahmen zur Vermeidung von Fehlern. Wenn sie gut durchgeführt werden, ist die effektive Kommunikation (darstellbar als ausgetauschte relevante Informationsmenge pro Zeiteinheit) hoch und ersetzt so manches uneffektive Folgemeeting. Nicht genügend effektive Kommunikation — es kann nicht bestritten werden, dass in vielen Firmen ausgiebig gemeetet wird — ist nach wie vor eine Hauptursache für Fehler aller Art in der Softwareentwicklung.

Sobald lauffähiger Code existiert, muss er unter realen Bedingungen ausgeführt werden und dabei Extremsituationen und allen denkbaren Fehlzuständen und -eingaben unterworfen werden. Dies geschieht durch Verfahren zur Kontrolle auf implementierte Fehler (siehe Beitrag

„Dynamische Softwaretests“, InfoClick). Hierbei werden nicht nur Fehler in der Implementierung an sich (wie vertauschte Vorzeichen, fehlende Initialisierung von Variablen etc.) aufgedeckt, sondern die gesamte Systemarchitektur wird unter realen Bedingungen auf Qualitätsmerkmale wie Angemessenheit, Robustheit, Bedienbarkeit und dergleichen überprüft.

Je nach Art der Software können Tests dieser Art langwierig und kostspielig sein - und werden deshalb aus Zeit- und Kostengründen gerne wegoptimiert, wenn sie denn jemals im Projektplan auftauchten. Selbst wenn das der Fall ist, sind nicht selten nur ein oder zwei Tage für höchst komplexe Softwarestücke vorgesehen - definitiv zu wenig.

Aufwand und Kosten müssen je Projekt abgewogen werden

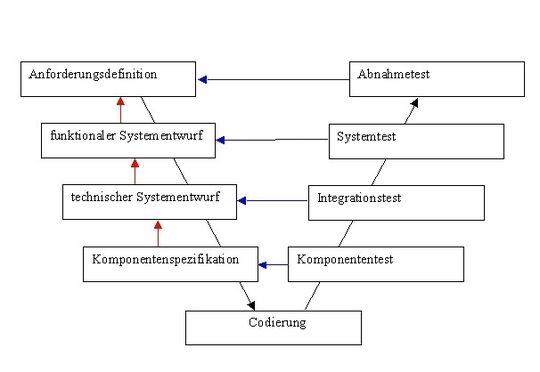

Testen sollte also ein wohldefinierter Prozess sein, der parallel zur Entwicklung läuft und sie in den einzelnen Projektphasen begleitet. Dies zeigt Bild 2: Am Übergang einer Projektphase zur nächsten verifizieren Reviews die Ergebnisse der abgeschlossenen Projektphase gegenüber der vorangegangenen, ob das Produkt richtig gebaut wird. Beispielsweise wird aus einem rein funktionalen Systementwurf (noch ohne technische Aspekte) in der anschließenden Phase ein technischer Systementwurf gemacht. Beim Abschluss dieser Phase sollte bereits ein ausreichendes Testverfahren eingeplant sein, um zu verifizieren, ob der funktionale Systementwurf korrekt und vollständig in den technischen Systementwurf umgesetzt wurde.

Ist das Projekt soweit gediehen, dass lauffähiger Code vorliegt und er schrittweise zu Teilsystemen und schließlich zum Gesamtsystem integriert werden kann, sollten die Ergebnisse der Codeintegration anhand der entsprechenden Designdokumente validiert werden: Zunächst sollte der Code auf Klassen- und Funktionsebene dynamisch getestet werden, wobei den Tests die Definition der Klasseninterfaces zugrundegelegt werden.

Im nächsten Schritt werden die Klassen zu Modulen zusammengefasst, die sich durch ihre Funktionalität definieren und die in einer Modul- oder Komponentenspezifikation festgelegt wurde. Auf dieser Ebene wird der Schwerpunkt des Tests darauf gelegt, ob das Modul die Aufgabe richtig löst, Grenzwerte einhält, bei Fehleingaben richtig reagiert. Wie es das im einzelnen macht, wurde zuvor im Klassen- (oder Unit-)Test überprüft.

So verschiebt sich bei zunehmender Integration der Module über Teilsysteme hinweg bis zum Gesamtsystem der Blickpunkt der Tests immer mehr auf die Prüfung der Zusammenarbeit der Einheiten untereinander. Im letzten Schritt, dem Abnahmetest, werden die ursprünglich festgelegten Eigenschaften des Produktes als Testziel verwendet.

Es ist klar, dass dieses Vorgehen einiges an Investition verlangt. Wo an Personalkosten nicht (mehr) eingespart werden kann, fallen besonders als überflüssig betrachtete Prüfprozesse dem Rotstift zum Opfer oder werden zusammengelegt, was bei hoher Softwarekomplexität nicht ratsam ist.

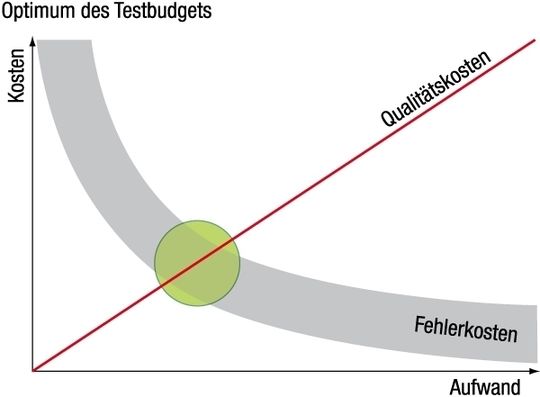

Es ist aber auch nicht sinnvoll, exzessiv viele Prüfschritte einzuführen (Bild 3). Die ihnen verbundenen Kosten werden ab einem gewissen Aufwand nicht mehr durch einen Gewinn an reduzierten Fehlerkosten aufgefangen: die Zahl an gefundenen Fehlern nimmt mit gesteigertem Aufwand nicht linear zu, sondern die Kurve flacht sich ab, ebenso die der potentiellen Fehlerkosten.

Optimal ist es daher, einen vertretbaren Grad an Durchtestung und verbleibendem Fehlerrisiko zu erreichen. Dieser Bereich ist in der Praxis schwer zu ermitteln und verlangt eine produktspezifische Risikokostenanalyse. Die Testkosten wiederum hängen sehr stark von der Test-Infrastruktur und dem verfügbaren Wissen um Testprozesse ab. Daneben spielen Kriterien wie Testbarkeit aufgrund der Art des Entwicklungsprozesses, Automatisierbarkeit, Reife der Software eine ausschlaggebende Rolle. Es kann durchaus sinnvoll sein, die Etablierung und Durchführung eines Testprozesses oder Teilen davon als Expertenleistung von außen einzukaufen.

*Dr. rer. nat. Richard H. Kölbl ist für die Firma Mixed Mode tätig. Seine Schwerpunkte sind die Etablierung, Durchführung und Verwaltung von Software-Testprozessen. Kontakt: rko@mixed-mode.de

(ID:253129)

:quality(80)/p7i.vogel.de/wcms/e6/72/e67279e23a3267a463edf3e3f55c8e81/0129260553v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/51/96/51962a77f2a4b260373b39a489f53df9/0129137248v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/fe/aa/feaa985d4c194037beaf377300204a9a/0129027271v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/c5/4bc5a6e591592fac9c3f05b77b8c237f/0129307845v4.jpeg)

:quality(80)/p7i.vogel.de/wcms/6c/22/6c22d187c749f899845158057cb92ad1/0129224894v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f5/51/f5516128b6a3176679f3291ef1f3c594/0129209328v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/57/7b5725dd2e7545ab4904a9b7a3735721/0129309389v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b2/9c/b29ce10d1817d4b67968dfb737d812b7/0129308255v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/f0/4cf066b46a5fcfc430a2454a5e82e801/0129279386v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/4e/f2/4ef224fde728985d8b9630eb0fa37909/0129293948v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/3f/0d/3f0d634d8c172031474c341b3a2b725e/0129262158v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/40/32/4032d23b67ab8a52bf472277dc70a64f/0129074969v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/0c/660c31afa35398bac9be42f2be73fdc4/0129073529v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/35/9c35ed04fa562b190cbc496a695a6802/0128823288v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d7/e6/d7e6fe4124ec2efc726e9c3f2c2a4cfc/0128241940v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/7d/68/7d68aecf780e15057f14df63731fb935/0127934402v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/c0/75c0d5ccd1cee4e66dbd5f3ed02efd0a/0129305300v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9b/c1/9bc1caaaf2b30471c3d187069d2d8e4b/0129101585v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9a/51/9a5199a5ad49e895b4aef7e04fe629e2/0129255110v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/d9/d6/d9d68c274ac9c3c728978fac46c773ba/0129239468v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/53/c35394add74d23226fbd5c65833c0774/0129209052v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/63/9e/639e76b1a5edc6cb79a45b63aefadcfd/0129234417v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/0c/57/0c57cee9533d090c98061b4352d1103d/0129219561v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ae/9a/ae9ad13f67e6dff52d1f20698c0edb64/0129210301v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/54/5f545ab3a8bf940444930f98c9db8255/0129304670v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/1f/691f39ba12be3cad90eb88bdabc456a6/0127321404v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/cc/6acc4f803241cfe5b6d60560c0a2b4d9/0126684948v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/aa/efaae5a25fb0a4c55c434611033447af/0126532350v2.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/64/21/64219ce08bf52/logo.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/5f/15/5f157c2d880f4/ish-logo2020.jpg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/68800/68851/65.jpg)

:quality(80)/p7i.vogel.de/wcms/eb/27/eb278f50bbeee24cdc36dc299aabe7cc/0125635006v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/81/e2/81e2300eaeb5ebf5ab354af0a88188da/0123055104v2.jpeg)