Anbieter zum Thema

An den Grenzen der effizienten Leistungssteigerung

Neben der Bitbreite gab es noch zwei weitere wesentliche Schrauben zur Erhöhung der Rechengeschwindigkeit: die Erhöhung des Taktes und die Erhöhung der Anzahl der Operationen (in einem Programm), die pro Takt durchführbar sind. Ersteres hat man leidlich ausgenutzt; die maximalen Betriebsfrequenzen können auch so schön auf die Verpackung gedruckt werden, und große Zahlen sind ein tolles Verkaufsargument. Jedenfalls fand das solange statt, bis Pat Gelsinger, damals CTO bei Intel, im Jahr 2001 deutlich machte, dass man etwa 2010 dann bei einer Verlustleistung einer CPU ankommen würde, die der Leistungsdichte der Sonne auf der Oberfläche entsprach. Die Sonne im Rechnergehäuse also - keine schöne Vorstellung, oder?

Über die andere Tuning-Schraube las man schon 1995 beim Institute of Electrical and Electronics Engineers (IEEE), dass man nun kurz davor stünde, die 4-fach parallel rechnenden CPUs superskalarer Bauart nun durch 16-fach rechnende CPUs superskalarer Bauart zu ergänzen, womit eine 4-fache Geschwindigkeitssteigerung einhergehen würde. 2003 konnte man diese Ankündigung erneut finden – ebenfalls beim IEEE. Seitdem hat man davon aber nichts mehr gehört.

Was war passiert? Vierfache Superskalarität bedeutet, dass man theoretisch vier Instruktionen parallel, also gleichzeitig ausführen kann. Das kostet grob geschätzt die 16-fache Siliziumfläche, aber Transistorknappheit ist nun wirklich nicht das Problem, nur bleiben davon im Schnitt 1,3 Instruktionen pro Takt übrig. Steigert man das auf die 16-fache Superskalarität, also die vielleicht 256fache Fläche, steigt die erhaltene Performance nur marginal. Ein schlechtes Geschäft also, das keiner wollte.

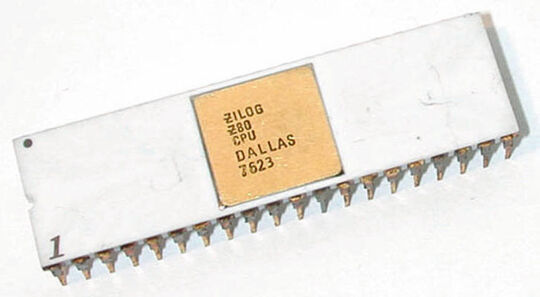

Überhaupt sind die technologischen Randbedingungen schlechter geworden. Der Mikroprozessor, der schon einmal als „der eigentlich größte Unfall der Technikgeschichte“ bezeichnet wurde, ist natürlich nicht wegzudenken, aber seine Weiterentwicklung in Richtung Geschwindigkeit des einzelnen Prozessors ist praktisch zum Erliegen gekommen. Die schöne Rechnung, dass bei einer relativen Skalierung S der Herstellungstechnologie die Anzahl der Transistoren mit S² und die Geschwindigkeit (Taktfrequenz) mit S skalieren während die Verlustleistung konstant bleibt (Dennard’sches Gesetz, 1974), findet einfach nicht mehr statt. Mann kann derzeit entweder die Geschwindigkeit erhöhen und dafür die Transistoren nicht mehr ausnutzen, oder man muss wesentlich mehr Verlustleistung, verbunden mit erheblichem Aufwand zur Kühlung, in Kauf nehmen. Man spricht auch von Dark Silicon.

Artikelfiles und Artikellinks

(ID:44145894)

:quality(80)/p7i.vogel.de/wcms/59/bf/59bfd2822d711b0ae2cb9383b679f38d/0129302533v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/94/c19403fe0194686b2f4911be7e1e9539/0129294209v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e6/72/e67279e23a3267a463edf3e3f55c8e81/0129260553v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/28/0f/280fe550dfb032b53edbaac11d09bced/0129337134v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/21/29218000af0daabca33bf8a7947b61ad/0129310204v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/2b/5d/2b5d6ddedab3fdcaf528ff1caf650433/0129302953v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/57/7b5725dd2e7545ab4904a9b7a3735721/0129309389v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b2/9c/b29ce10d1817d4b67968dfb737d812b7/0129308255v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/c5/4bc5a6e591592fac9c3f05b77b8c237f/0129307845v4.jpeg)

:quality(80)/p7i.vogel.de/wcms/61/85/6185c7a5619aba866e3b237690bea839/0129334467v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/88/3c8863ad57e80adc0acb9c9d9ea30351/0129319571v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4e/f2/4ef224fde728985d8b9630eb0fa37909/0129293948v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/c7/f6/c7f61d0437c7f8fca3c6ff947ba2ad62/0129322490v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/0c/660c31afa35398bac9be42f2be73fdc4/0129073529v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/35/9c35ed04fa562b190cbc496a695a6802/0128823288v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d7/e6/d7e6fe4124ec2efc726e9c3f2c2a4cfc/0128241940v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e6/0a/e60ae162bd38bfc111ecf434d5c5fbd7/0129308123v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/75/c0/75c0d5ccd1cee4e66dbd5f3ed02efd0a/0129305300v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/a7/8c/a78c5f851db209abb1540909918fbf4a/0129260768v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9a/51/9a5199a5ad49e895b4aef7e04fe629e2/0129255110v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/d9/d6/d9d68c274ac9c3c728978fac46c773ba/0129239468v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/52/7a/527ad5ae7d10b9e34b72570639d7870c/plagiarius-zwerg-gnome-2849x1602v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/43/4343a389b15f84f683b7d1cdb4745d23/0129331527v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/89/6b/896bbee46d0440c8a01ce4d0dab325f0/0129302555v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/1f/691f39ba12be3cad90eb88bdabc456a6/0127321404v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/cc/6acc4f803241cfe5b6d60560c0a2b4d9/0126684948v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/aa/efaae5a25fb0a4c55c434611033447af/0126532350v2.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/f6/66f673630a98a/logo-mc-rgb-300x300.png)

:fill(fff,0)/p7i.vogel.de/companies/62/5e/625ea073a6efe/eepd-just-embedded-4zu1.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/123800/123857/65.jpg)

:quality(80)/p7i.vogel.de/wcms/79/53/795340eb0320c154f1753a83c54bfb0b/0125717605v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/58/f3582418b9336007cdda0204bc1fb934/0125085585v1.jpeg)