Grundlagen der Kameratechnik Worauf es bei der Auswahl des richtigen Bildsensors ankommt

Hersteller digitaler Fotoapparate und Kamerahandys buhlen mit immer neuen Multi-Megapixel-Neuheiten und Monster-Zoomobjektiven um die Gunst des Konsumenten. Diese Pixel- und Zoom-Woge erfasst auch industrielle Bildverarbeiter. Doch wie gut oder schlecht eine Szene erfasst wird, entscheidet nicht die Menge der Bildpunkte. Der Beitrag erklärt, welche Faktoren generell und im speziellen die in industriellen Applikationen erforderliche hohe Bildqualität ausmachen.

Anbieter zum Thema

Je mehr Pixel ein Sensor hat, desto feiner kann man das auf den Sensor projizierte Bild auflösen. Doch ein Pixel besteht nicht nur aus der fotoempfindlichen Fläche, sondern auch aus Mikroelektronik, die zum Beispiel die generierten Ladungen abtransportieren oder in eine Spannung wandeln. Wird ein Pixel kleiner, reduziert sich oft der fotoempfindliche Anteil, weil die umliegende Mikroelektronik gleich groß bleibt. Je kleiner die fotoempfindliche Fläche ist, desto weniger Elektronen werden damit gesammelt. Die maximale Anzahl an gesammelten Elektronen nennt man Full-Well-Kapazität.

Die physikalische Grenzen des Bildsensors

Aus der Full-Well-Kapazität resultiert das maximale Signal-Rausch-Verhältnis (Wurzel aus der Full-Well-Kapazität), was allerdings nicht mit der Dynamik des Sensors verwechselt werden darf: Dynamik ist das Verhältnis der Full-Well-Kapazität zum Dunkelrauschen, denn das Dunkelrauschen definiert die Detektionsgrenze (oder Sensitivität). Diese Detektionsgrenze ist erreicht, wenn die durch Licht erzeugten Elektronen gleich der Anzahl der Elektronen aus dem Dunkelrauschen sind. Je kleiner der Pixel ist, desto schlechter werden Signal-Rausch-Verhältnis und Dynamik des Pixels.

Die Optik ist ein limitierender Faktor

Neben diesen physikalischen Grenzen auf Seiten des Sensors, treten aber vor allem bei der Hardware Restriktionen auf, die mit darüber entscheiden, ob man ein gutes Bild erhält oder nicht. In den meisten Fällen ist die Abbildungsleistung der Optik der limitierende Faktor. Wird ein winziger Punkt durch das Objektiv auf dem CCD- oder CMOS-Sensor abgebildet, so liegen die Spotgrößen bei 15 µm Durchmesser für einfache Objektive. Gute Objektive schaffen einen Durchmesser von 5 bis 7 µm, sehr gute Objektive sogar unter 5 µm.

Ein Objektiv besteht aus mehreren Linsen, die so aufeinander abgestimmt sind, dass Abbildungsfehler minimiert werden. Doch auch die beste Kombination von Linsen stößt an eine physikalische Grenze, die Beugung genannt wird. Sie verringert die Abbildungsqualität und begrenzt das Auflösungsvermögen. Als Daumenregel gilt: Man nimmt die Blendenzahl des Objektivs als Wert in µm und erhält den Durchmesser der Unschärfe, die von der Beugung kommt. Beispielsweise ergibt Blende 5,4 eine Unschärfe von 5,4 µm auf dem Sensor.

Kleinerer Pixel bedeuten geringere Einbautoleranz

Werden die Pixel kleiner, wachsen gleichzeitig die Anforderungen an die maximale Verkippung der Sensoren in der Kamera, weil die Schärfentiefe nachlässt. Diese nimmt proportional mit der Blendenzahl und der Pixelgröße ab. Bei einem 10 µm großem Pixel konnte bei einer Blendenzahl von 2,8 die maximale Verkippung noch ± 28 µm über den gesamten Sensor zugelassen werden. Bei einem Pixel mit 5 µm Kantenlänge sind nur noch ± 14 µm tolerierbar. Wird das Objektiv bei einer Blendenzahl von 1,4 betrieben, halbiert sich der Toleranzbereich nochmals.

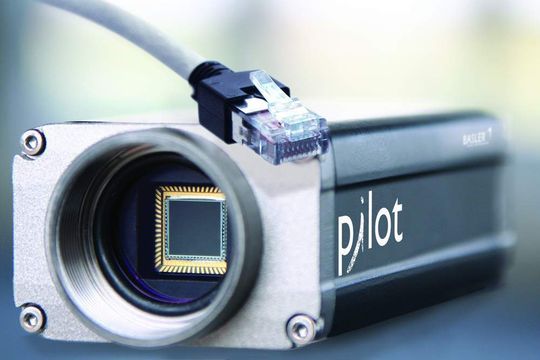

Hersteller sind somit zunehmend gefordert, den Sensor immer genauer in der Kamera zu positionieren. Dieses geschieht bei führenden Kameraherstellern inzwischen durch hochpräzise Einmess- und Positioniersysteme. Basler Vision Technologies beispielsweise hat eigene Geräte entwickelt, die Kalibrierungsroutinen für die Sensor- und Inbetriebnahmeparameter der Kamera sowie zahlreiche weitere Qualitätstests umfassen. Nur so lässt sich die Genauigkeit gewährleisten, die etwa für Inspektions- und Messaufgaben in der Wafer- oder Elektronikindustrie erforderlich ist.

Objektive sind für ihre Anwendung genau berechnet

Auch der Einsatz des richtigen Objektivs spielt eine entscheidende Rolle für die Bildqualität. Objektive werden für gewisse Parameter wie zum Beispiel den Abbildungsmaßstab entwickelt. Die mechanische Konstruktion setzt dieses dann in den Hub um, so dass von Objektweite unendlich bis beispielsweise 30 cm fokussiert werden kann. Setzt man einen Abstandsring zwischen Objektiv und Ka-mera, kann man Objekte ansteuern, die näher sind, jedoch lässt die Bildqualität stark nach, denn das Objektiv ist darauf ursprünglich nicht ausgelegt.

Konstruieren Optikentwickler ein Zoom-Objektiv, stehen sie vor der technischen Herausforderung, die optischen Parameter so anzupassen, dass sie über den gesamten Zoombereich ein konstant gutes Bild liefern. Muss ein Objektiv nur mit einer Brennweite und ggf. nur einem Ab-bildungsmaßstab konstruiert werden, ist dies mit weniger technischen Randbedingungen behaftet, sodass normale Objektive den Zoomobjektiven vorgezogen werden sollten. Nicht nur der Abbildungsmaßstab (Verhältnis Bildgröße zur Objektgröße), sondern auch die Bildgröße ist Parameter eines Objektives.

Der 1˝-Zoll-Sensor misst in der Diagonale nur 15,875 mm

Die Größe von CCD- und CMOS-Sensoren wird oft in Zoll (oder Inch) über die Bilddiagonale angegeben. Gebräuchliche Größen sind 1/6˝, 1/4˝ , 1/3˝, 1/2˝, 2/3˝ und 1˝. Diese Maßangabe entspricht allerdings nicht dem Wert, der sich aus der Umrechnung 1" = 25,4 mm ergibt. Das hat historischen Hintergrund. Ein Sensor mit einer Diagonalen von 1" hat tatsächlich eine Diagonale von nur rund 16 mm. Diese CCD/CMOS-Sensorgröße entspricht einer fotoempfindlichen Schicht, der früher in einer Bildaufnahmeröhre enthalten war, deren Außendurchmesser 1" betrug. Dies ist leider irreführend, insbesondere im angloamerikanischen Raum. Das historisch bedingte Zoll-Äquivalent wird ebenfalls bei der Beschreibung der Objektive für die industrielle Bildverarbeitung angegeben. So kann ein Objektiv mit einem Bildkreisdurchmesser von 2/3" nur für Sensoren eingesetzt werden, deren Diagonale nicht mehr als rund 11 mm beträgt.

Die Pixelgröße und Bilddarstellung

Die meisten Sensoren in der Bildverarbeitung haben zwischen 5 und 10 µm Pixelgröße. Es kommen jedoch auch kleinere Pixelgrößen zum Einsatz, weil inzwischen viele Sensoren genutzt werden, die auch in Digitalkameras für den Konsummarkt Verwendung finden. So sind heute durchaus Pixelgrößen von 2,35 µm üblich. Und wie viele Pixel braucht man für ein gutes Bild?

Ein Fernseher mit PAL-Auflösung hat 768 × 576 Bildpunkte, also nur 0,44 Megapixel. Ein Monitor für den PC hat mit 1280 × 1024 Pixeln insgesamt 1,3 Megapixel. Hochauflösendes Fernsehen HDTV verfügt über 1920 × 1080 Bildpunkte Auflösung, hat also 2 Megapixel. Wenn man Bilder ausdruckt, so hat man bei einem 13 cm × 9 cm großen Fotoabzug mit 300 dpi Auflösung (dots per inch, Punkte pro Zoll) 1,6 Megapixel, bei einer Seite im Format DIN A4 mit 300 dpi sind es 8,7 Megapixel. Es wird deutlich, dass die Auflösungen von Kamera und Anzeigegerät aufeinander angepasst sein müssen. Daher ist es beispielsweise wenig sinnvoll, die Bilder der privaten Digitalkamera mit 8 oder 9 Megapixeln auf dem normalen Fernseher anzusehen, weil lediglich die TV-Auflösung wiedergegeben wird.

Ein Farbsensor mit Bayer-Muster

Hinsichtlich der Größe eines Pixels ist zudem von Bedeutung, ob man einen Schwarzweiß-Sensor (Monochrom-Sensor) oder einen Farbsensor einsetzt. Die meisten Farbsensoren arbeiten mit einem Bayer-Muster. Ihre einzelnen Pixel einer ungeraden Zeile sind abwechselnd mit einem roten und einem grünen Filter überzogen, die geraden Zeilen wechseln zwischen grünen und blauen Filtern. Hieraus gewinnt man die Farbinformation für Rot, Grün und Blau. Mit unterschiedlichen Algorithmen wird dann ein echtes Farbbild errechnet.

Damit erweitert sich die eigentliche Pixelgröße auf ein 2 × 2 großes Pixel, sodass Rot, Grün und Blau zu einem Farbpixel zusammen gefasst werden können. Die Algorithmen bilden einen Kompromiss zwischen bester Farbe und bester Auflösung. Dadurch, dass effektiv ein 2 × 2 großes Pixel zur Berechnung der Farbauflösung genutzt wird, relativieren sich auch die Pixelgrößen. Ein Farbsensor mit 5 µm großen Pixeln hat quasi die gleiche räumliche Auflösung wie ein 10 µm großes monochromes Pixel.

In der industriellen Bildverarbeitung werden meist monochrome Kameras eingesetzt, weil sich Maßhaltigkeiten und Formen oftmals besser mit einem Graubild verarbeiten lassen. Ein weiterer Vorteil: Alle Pixel sind gleich, denn es liegt kein Bayer-Muster auf dem Sensor. Farbbilder dienen hier oft nur der Visualisierung für den Anwender. Es gibt jedoch zunehmend industrielle Applikationen, insbesondere in der Nahrungsmittelindustrie, in denen die Farbtreue eines Objekts zu prüfen ist, so dass man diese Thematik entsprechend berücksichtigen muss.

In jeder Sekunde mehr als eine CD voller Daten

Im privaten Bereich möchte man die aufgenommenen Bilder auf dem Monitor oder Fernseher zeigen oder Fotoabzüge fürs Album machen. Das ist in der industriellen Bildverarbeitung anders: Hier müssen die aufgenommenen Bilder möglichst schnell verarbeitet werden, es müssen Kanten oder Formen gefunden, Texte gelesen oder andere Analysen durchgeführt werden. Leistungsstarke Frame-Grabber haben die Aufgabe, diese zum Teil sehr großen Datenmengen zu filtern und zu bearbeiten. So kann beispielsweise eine 4-Megapixel-Kamera über 200 Bilder/s liefern. Das sind in jeder Sekunde über 800 Megabyte Daten mehr als auf eine CD passt!

Industrielle Bildverarbeitung braucht unkomprimierte Bilder

Bei Konsumdigitalkameras werden die Bilder durch den integrierten Image-Prozessor bereits in der Kamera zu JPG-Bildern komprimiert, was für private Zwecke sehr gut funktioniert. Doch diese Komprimierung weist Grenzen auf. Bei starken Kontrastübergängen, wie bei gedrucktem Text, treten wellenförmige Artefakte auf, die für viele Applikationen in der industriellen Bildverarbeitung nicht tolerierbar sind. Dort liegen die Anforderungen an Bildqualität und Zuverlässigkeit deutlich höher, sodass im Normalfall unkomprimierte Bilder übertragen und die hohen Datenmengen anderweitig zu bewältigen sind.

Weniger Pixel ist nicht selten von Vorteil

Wie bereits deutlich geworden ist, sollte bei einer Konsumkamera die Pixelzahl auf das Anzeigegerät abgestimmt sein. Werden von den digitalen Bildern Papierabzüge gemacht, müssen Größe des Abzugs und Auflösung berücksichtigt werden. Doch nicht jeder will sich Poster machen lassen. Das heißt, eine Digitalkamera mit weniger Megapixeln ist möglicherweise die bessere Wahl, denn sie liefert das bessere Bild, weil die Pixel größer sind und dadurch ein besseres Signal-Rausch-Verhältnis und Dynamik aufweisen.

*Dr. Joachim Linkemann ist Produktmanager bei Basler Vision Technologies, Ahrensburg.

(ID:259836)

:quality(80)/p7i.vogel.de/wcms/ce/09/ce09cbfd70dd50b7f8e9e923c4fd8f3d/0129481054v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/59/bf/59bfd2822d711b0ae2cb9383b679f38d/0129302533v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/94/c19403fe0194686b2f4911be7e1e9539/0129294209v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f4/6d/f46dc3cf56ae837fb855d88077339d7e/0129471887v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/23/eb23785d23e0a13df6f6344f6d880bd0/0129487941v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/51/c95190c4593352afdbbd194429b7ec7f/0129455974v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/3f/69/3f69e2ac28f7f9ee735680c5e5d53d94/0129470810v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/57/7b5725dd2e7545ab4904a9b7a3735721/0129309389v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b1/77/b1770e7d7499d7f807a2d5236dc081c8/0129461958v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/c0/8ec08a2db5562f6cbe50d673f4fccde7/0129471934v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/1d/e5/1de5e11918cfb261b8b5c4632fc1f7db/0129456364v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/e8/a8/e8a8a953c77af9bbf208cce6454139d4/0129427931v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/61/85/6185c7a5619aba866e3b237690bea839/0129334467v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/c7/f6/c7f61d0437c7f8fca3c6ff947ba2ad62/0129322490v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/0c/660c31afa35398bac9be42f2be73fdc4/0129073529v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/35/9c35ed04fa562b190cbc496a695a6802/0128823288v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d7/e6/d7e6fe4124ec2efc726e9c3f2c2a4cfc/0128241940v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/a6/7d/a67d43c748dc7ed8ac050a063332cac8/0129435600v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/cf/0f/cf0f3362847d47d5555e5a95088af28a/0129398250v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/bc/42/bc42dd0a04818f6195a7f78bcec88be6/0129484567v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/14/63/14635e09eff181f7ab7a0f81ffa0daa3/0129407664v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/e4/ffe44f0dcf0fc0323926b1bc0a60d94f/0129386849v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/a7/8c/a78c5f851db209abb1540909918fbf4a/0129260768v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/8d/c18d63684ca54c0243a024818cd24010/0129458206v4.jpeg)

:quality(80)/p7i.vogel.de/wcms/64/64/64647ffd4b3e3ffce4086083807d4b01/0129435534v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9d/0e/9d0e614ed250fdbd9c4596be3c2c4ee8/0129459897v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/bf/5b/bf5b7894da75c9ea4c779f4ef665dfb9/0129484080v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/a8/eea894abb0f1f0844bcb12edb6e50d71/0129450905v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/80/35/80357a787685889f23ad77aafe07891c/0129452653v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/1f/691f39ba12be3cad90eb88bdabc456a6/0127321404v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/6a/cc/6acc4f803241cfe5b6d60560c0a2b4d9/0126684948v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/aa/efaae5a25fb0a4c55c434611033447af/0126532350v2.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/63/88/63887b860cf66/me-logo-400px.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/69/72/69721860571ff/logo.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/68800/68851/65.jpg)

:quality(80)/p7i.vogel.de/wcms/29/21/29218000af0daabca33bf8a7947b61ad/0129310204v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/df/01dfcc9dda687b8274d30fd2c3cf3eeb/0125373898v2.jpeg)